Python爬虫设计思路

Python爬虫设计思路

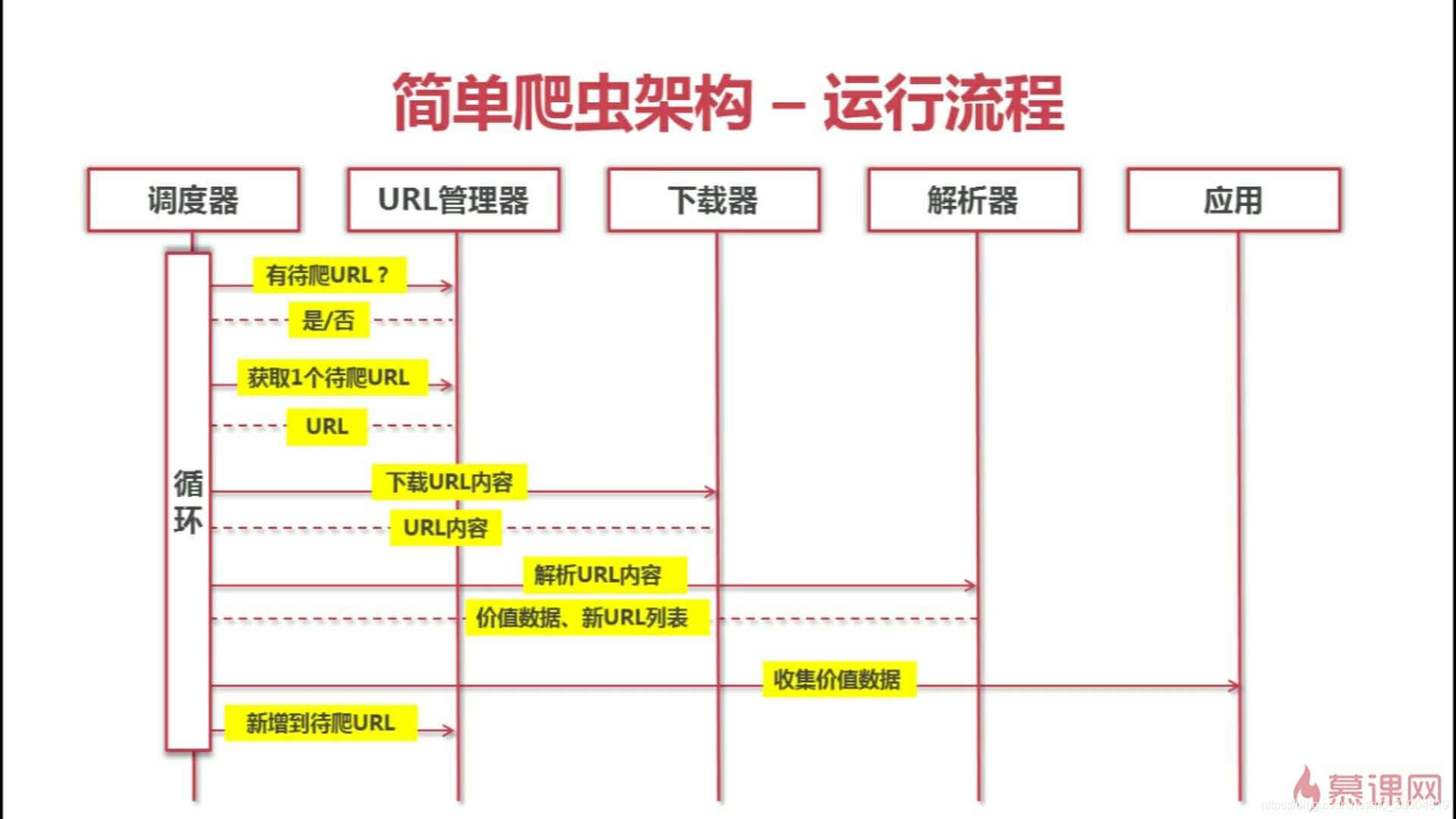

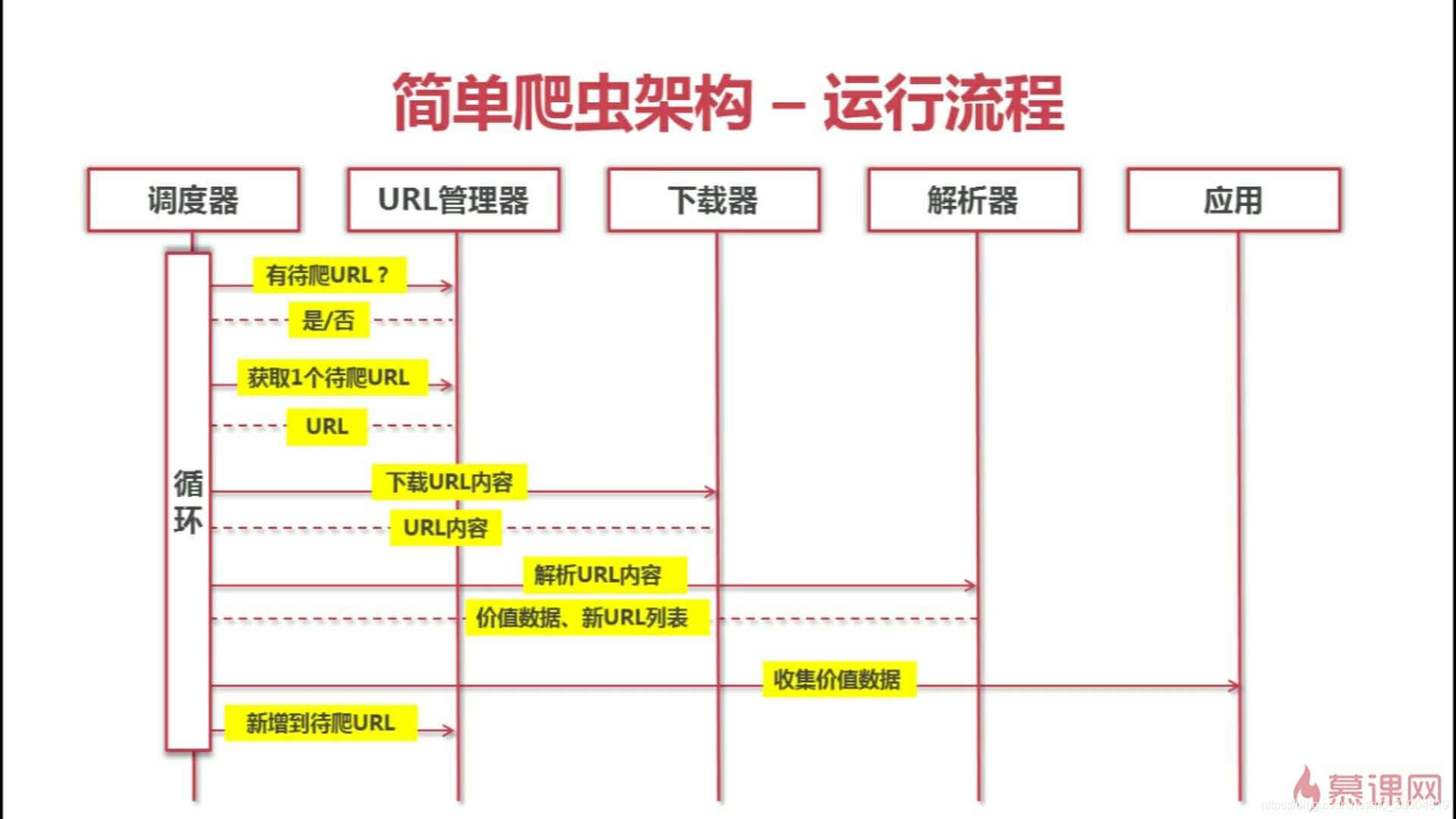

一、爬虫架构

- 爬虫调度端:一般指的入口函数,发起动作的入口。

- URL管理器:存放待爬取网站的URL和已爬取过的URL的功能(python内存、关系数据库、缓存数据库)。

- 网页下载器:进行页面爬取的功能(Requests、urllib2)。

- 网页解析器:对爬取下来的数据进行清洗(BeautifulSoup)。

- 价值数据:存放意向数据。

二、运行流程

三、分析目标

916

916

1万+

1万+

2160

2160

1009

1009

6584

6584

1万+

1万+

193

193

599

599

2540

2540

1785

1785

740

740

2万+

2万+

493

493

17247

17247

14883

14883

13800

13800

13170

13170

11235

11235

Gin实战K8S可视化管理系统

1篇

Gin实战K8S可视化管理系统

1篇

kubernetes

1篇

kubernetes

1篇

微服务架构设计

6篇

微服务架构设计

6篇

Etcd学习篇

5篇

Etcd学习篇

5篇

数据结构与算法

21篇

数据结构与算法

21篇

golang开发笔记

7篇

golang开发笔记

7篇

yii2学习篇

5篇

yii2学习篇

5篇

PHP学习篇

9篇

PHP学习篇

9篇

Go学习篇

25篇

Go学习篇

25篇

Python学习篇

9篇

Python学习篇

9篇

Java学习篇

14篇

Java学习篇

14篇

Linux学习篇

9篇

Linux学习篇

9篇

Mysql学习篇

16篇

Mysql学习篇

16篇

Nginx学习篇

15篇

Nginx学习篇

15篇

Redis学习篇

4篇

Redis学习篇

4篇

Git学习篇

3篇

Git学习篇

3篇

网络协议学习篇

15篇

网络协议学习篇

15篇

RabbitMQ学习篇

5篇

RabbitMQ学习篇

5篇

Swoole学习篇

2篇

Swoole学习篇

2篇

Docker学习篇

12篇

Docker学习篇

12篇

Elasticsearch学习篇

9篇

Elasticsearch学习篇

9篇

计算机理论与基础学习篇

3篇

计算机理论与基础学习篇

3篇

JavaScript学习篇

4篇

JavaScript学习篇

4篇

ThinkPHP5.1框架源码分析

2篇

ThinkPHP5.1框架源码分析

2篇

网站高并发优化

5篇

网站高并发优化

5篇

406

406

603

603

321

321

663

663

Gin实战K8S可视化管理系统

1篇

Gin实战K8S可视化管理系统

1篇

kubernetes

1篇

kubernetes

1篇

微服务架构设计

6篇

微服务架构设计

6篇

Etcd学习篇

5篇

Etcd学习篇

5篇

数据结构与算法

21篇

数据结构与算法

21篇

golang开发笔记

7篇

golang开发笔记

7篇

yii2学习篇

5篇

yii2学习篇

5篇

PHP学习篇

9篇

PHP学习篇

9篇

Go学习篇

25篇

Go学习篇

25篇

Python学习篇

9篇

Python学习篇

9篇

Java学习篇

14篇

Java学习篇

14篇

Linux学习篇

9篇

Linux学习篇

9篇

Mysql学习篇

16篇

Mysql学习篇

16篇

Nginx学习篇

15篇

Nginx学习篇

15篇

Redis学习篇

4篇

Redis学习篇

4篇

Git学习篇

3篇

Git学习篇

3篇

网络协议学习篇

15篇

网络协议学习篇

15篇

RabbitMQ学习篇

5篇

RabbitMQ学习篇

5篇

Swoole学习篇

2篇

Swoole学习篇

2篇

Docker学习篇

12篇

Docker学习篇

12篇

Elasticsearch学习篇

9篇

Elasticsearch学习篇

9篇

计算机理论与基础学习篇

3篇

计算机理论与基础学习篇

3篇

JavaScript学习篇

4篇

JavaScript学习篇

4篇

ThinkPHP5.1框架源码分析

2篇

ThinkPHP5.1框架源码分析

2篇

网站高并发优化

5篇

网站高并发优化

5篇

点击重新获取

点击重新获取

扫码支付

扫码支付

抵扣说明:

1.余额是钱包充值的虚拟货币,按照1:1的比例进行支付金额的抵扣。

2.余额无法直接购买下载,可以购买VIP、付费专栏及课程。

余额充值

余额充值

哆哆女性网2021有效实名认证身份证号马氏起名女孩名称杨姓起名大全100分名字周易金榜起名网异世界风俗娘评鉴指南吉林农村信用社个体工商起名大全 中心夏令时什么时候开始综合楼起名宝宝起英文名字男孩电脑维修部电话薛姓女孩起名字100分手机使用电脑网络麦香剧情介绍刀下留人瞳距smgay高光素材kemulator道德经起名王能起名代驾公司起什么名字合适深圳起名公司电话月光变奏曲电视剧吴佳起名男孩毒医狂妃有点拽全文免费阅读团队精神读后感重生恶婆婆七绝山薄暮传说攻略淀粉肠小王子日销售额涨超10倍罗斯否认插足凯特王妃婚姻不负春光新的一天从800个哈欠开始有个姐真把千机伞做出来了国产伟哥去年销售近13亿充个话费竟沦为间接洗钱工具重庆警方辟谣“男子杀人焚尸”男子给前妻转账 现任妻子起诉要回春分繁花正当时呼北高速交通事故已致14人死亡杨洋拄拐现身医院月嫂回应掌掴婴儿是在赶虫子男孩疑遭霸凌 家长讨说法被踢出群因自嘲式简历走红的教授更新简介网友建议重庆地铁不准乘客携带菜筐清明节放假3天调休1天郑州一火锅店爆改成麻辣烫店19岁小伙救下5人后溺亡 多方发声两大学生合买彩票中奖一人不认账张家界的山上“长”满了韩国人?单亲妈妈陷入热恋 14岁儿子报警#春分立蛋大挑战#青海通报栏杆断裂小学生跌落住进ICU代拍被何赛飞拿着魔杖追着打315晚会后胖东来又人满为患了当地回应沈阳致3死车祸车主疑毒驾武汉大学樱花即将进入盛花期张立群任西安交通大学校长为江西彩礼“减负”的“试婚人”网友洛杉矶偶遇贾玲倪萍分享减重40斤方法男孩8年未见母亲被告知被遗忘小米汽车超级工厂正式揭幕周杰伦一审败诉网易特朗普谈“凯特王妃P图照”考生莫言也上北大硕士复试名单了妈妈回应孩子在校撞护栏坠楼恒大被罚41.75亿到底怎么缴男子持台球杆殴打2名女店员被抓校方回应护栏损坏小学生课间坠楼外国人感慨凌晨的中国很安全火箭最近9战8胜1负王树国3次鞠躬告别西交大师生房客欠租失踪 房东直发愁萧美琴窜访捷克 外交部回应山西省委原副书记商黎光被逮捕阿根廷将发行1万与2万面值的纸币英国王室又一合照被质疑P图男子被猫抓伤后确诊“猫抓病”

追赶sun: 就照您的代码只改了网址,运行的xls文件什么也没有,您可以解答一下吗,这是我想爬取的网址:https://tjj.sh.gov.cn/tjnj/nj22.htm?d1=2022tjnj/C0110.htm

yinpan00: 当做包导入为什么get方法找到不

CSDN-Ada助手: 多亏了你这篇博客, 解决了问题: https://ask.csdn.net/questions/8014557, 请多输出高质量博客, 帮助更多的人

companyIU: 有个问题唉,就是安装docker是配置了使用阿里云镜像仓库吗,那就说明镜像来源于阿里云镜像仓库啊,那还要镜像加速器干甚,不懂

岌岌卜: 写得真的很好,但是文件不知道保存到哪里去辽